Witaj! Przygotujmy się razem do egzaminu z Rekurencyjnych Sieci Neuronowych (RNN) jako Systemów Dynamicznych. Dasz radę!

Wprowadzenie do Systemów Dynamicznych

Zacznijmy od podstaw. Czym jest system dynamiczny? To system, którego stan zmienia się w czasie.

Myśl o wahadle, pogodzie, albo populacji królików. Ich stan ulega ewolucji.

Przestrzeń stanów to zbiór wszystkich możliwych stanów systemu. Dla wahadła to położenie i prędkość. Dla pogody to temperatura, ciśnienie i wilgotność.

Równanie ewolucji opisuje, jak stan zmienia się w czasie. Określa, jak system przechodzi z jednego stanu do drugiego.

Punkty Stałe i Atraktory

Punkt stały (punkt równowagi) to stan, w którym system pozostaje, jeśli zacznie od niego. Wahadło nieruchome w najniższym punkcie to przykład.

Atraktor to zbiór stanów, do których system zmierza z różnych początkowych stanów. Może to być punkt stały, ale też bardziej złożony kształt.

Wyobraź sobie umywalkę. Woda spływa do odpływu – odpływ to atraktor.

Rekurencyjne Sieci Neuronowe (RNN)

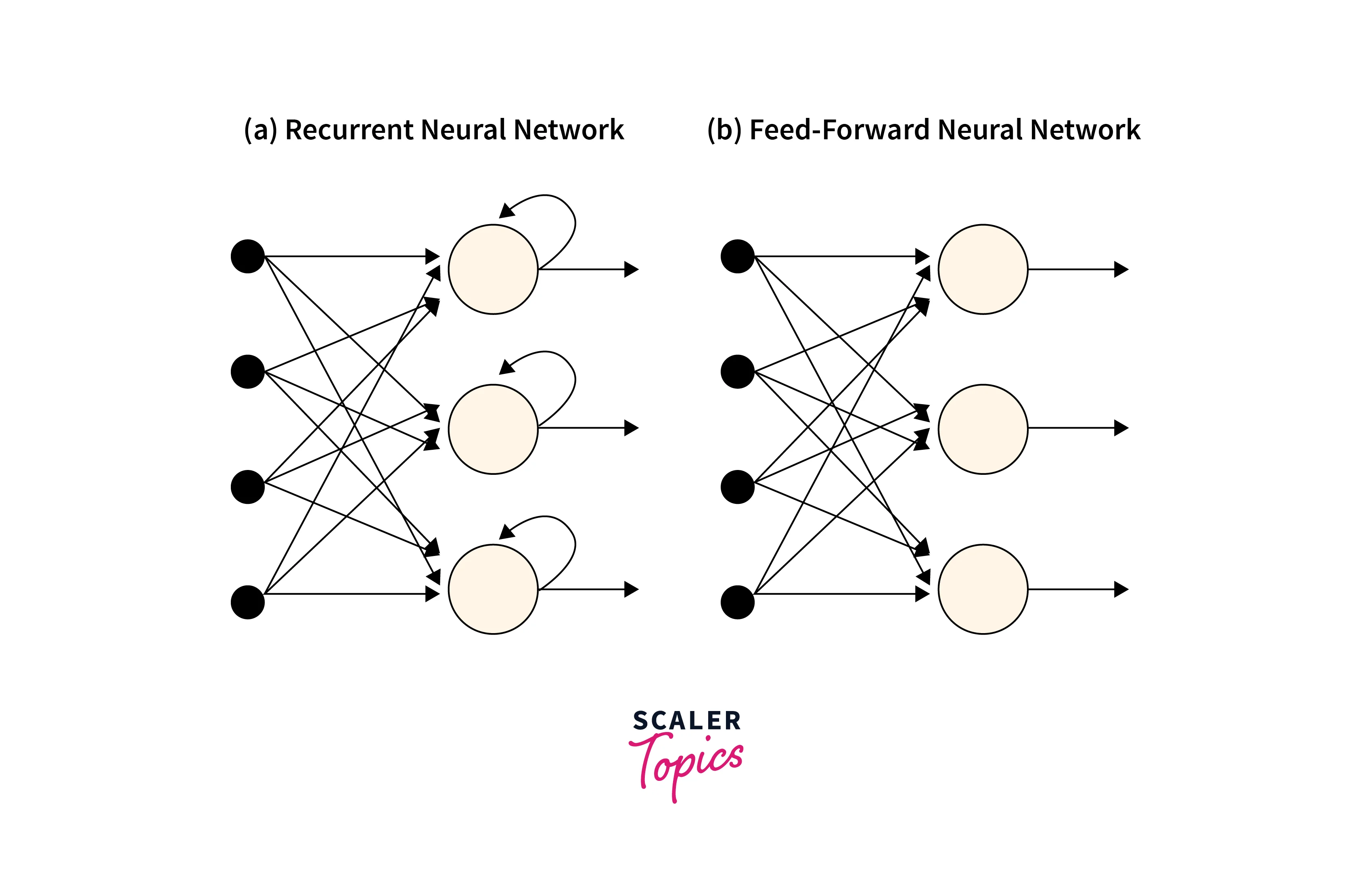

Teraz RNN. To sieci neuronowe zaprojektowane do przetwarzania sekwencji danych.

Myśl o tekście, mowie, czy szeregach czasowych. RNN są w tym dobre.

RNN mają stan wewnętrzny (ukrytą warstwę), który przechowuje informacje o poprzednich krokach sekwencji. To ich pamięć.

Kluczowa operacja to rekurencja. Wyjście z poprzedniego kroku wpływa na obecny krok.

Wzór ogólny: ht = f(ht-1, xt), gdzie ht to stan w kroku t, xt to wejście w kroku t, a f to funkcja aktywacji.

RNN jako Systemy Dynamiczne

Połączenie tych dwóch pojęć jest fascynujące. Możemy potraktować RNN jako system dynamiczny.

Stan ukryty RNN (ht) odpowiada stanowi systemu dynamicznego.

Funkcja aktualizacji stanu RNN (f) odpowiada równaniu ewolucji.

Zatem RNN ewoluuje w czasie, tak jak system dynamiczny. To pozwala nam analizować je używając narzędzi z teorii systemów dynamicznych.

Trajektoria RNN to sekwencja stanów ukrytych w czasie. Możemy obserwować, jak zmienia się stan RNN podczas przetwarzania sekwencji.

Analiza Stabilności RNN

Jednym z ważnych aspektów jest stabilność RNN. Czy sieć zbiega do punktu stałego? Czy oscyluje?

Eksplodujące i zanikające gradienty to problemy związane z trenowaniem RNN. Mogą prowadzić do niestabilności.

Techniki takie jak obcinanie gradientów (gradient clipping) pomagają stabilizować proces uczenia.

Analiza Lyapunov'a może być użyta do oceny stabilności punktów stałych w RNN. Pomaga zrozumieć, czy stan RNN zbiega się do określonego punktu.

Zastosowania

Rozumienie RNN jako systemów dynamicznych ma wiele zastosowań. Pomaga w projektowaniu i analizie tych sieci.

Generowanie sekwencji: RNN mogą generować tekst, muzykę, czy inne sekwencje. Analiza ich dynamiki pozwala na lepszą kontrolę generowanego wyjścia.

Rozpoznawanie wzorców: RNN mogą rozpoznawać wzorce w danych. Analiza stabilności pomaga zrozumieć, jakie wzorce są łatwo rozpoznawalne, a jakie trudniejsze.

Kontrola: RNN mogą być używane do sterowania systemami dynamicznymi. Analiza ich dynamiki pozwala na projektowanie stabilnych i efektywnych kontrolerów.

Bardziej Zaawansowane Modele

LSTM (Long Short-Term Memory) i GRU (Gated Recurrent Unit) to bardziej zaawansowane typy RNN.

Rozwiązują problem zanikających gradientów, umożliwiając uczenie się długoterminowych zależności.

Mają mechanizmy bramkowania, które kontrolują przepływ informacji w sieci.

Bramki (gates) decydują, które informacje zachować, a które zapomnieć.

Analiza dynamiki LSTM i GRU jest bardziej złożona, ale nadal opiera się na tych samych zasadach.

Podsumowanie

Pamiętaj, kluczowe punkty to:

- System dynamiczny: System zmieniający się w czasie.

- Przestrzeń stanów: Zbiór wszystkich możliwych stanów.

- Równanie ewolucji: Opisuje zmiany stanu.

- Punkt stały: Stan, w którym system pozostaje.

- Atraktor: Stan lub zbiór stanów, do których system zmierza.

- RNN: Sieć neuronowa przetwarzająca sekwencje.

- Stan ukryty: Pamięć RNN.

- RNN jako system dynamiczny: Stan ukryty = stan systemu, funkcja aktualizacji = równanie ewolucji.

- Stabilność: Czy sieć zbiega do punktu stałego, czy oscyluje?

- LSTM i GRU: Bardziej zaawansowane RNN z mechanizmami bramkowania.

Powodzenia na egzaminie! Jesteś dobrze przygotowany. Pamiętaj o zrozumieniu podstawowych pojęć i ich wzajemnych relacji. Wizualizuj sobie te koncepcje, a na pewno poradzisz sobie świetnie!